Mãe processa empresa de IA após suicídio de filho adolescente, impulsionando debate sobre responsabilidade tecnológica

Caso de morte de jovem de 14 anos, influenciado por chatbot, avança na justiça dos EUA e pode redefinir limites da inteligência artificial.

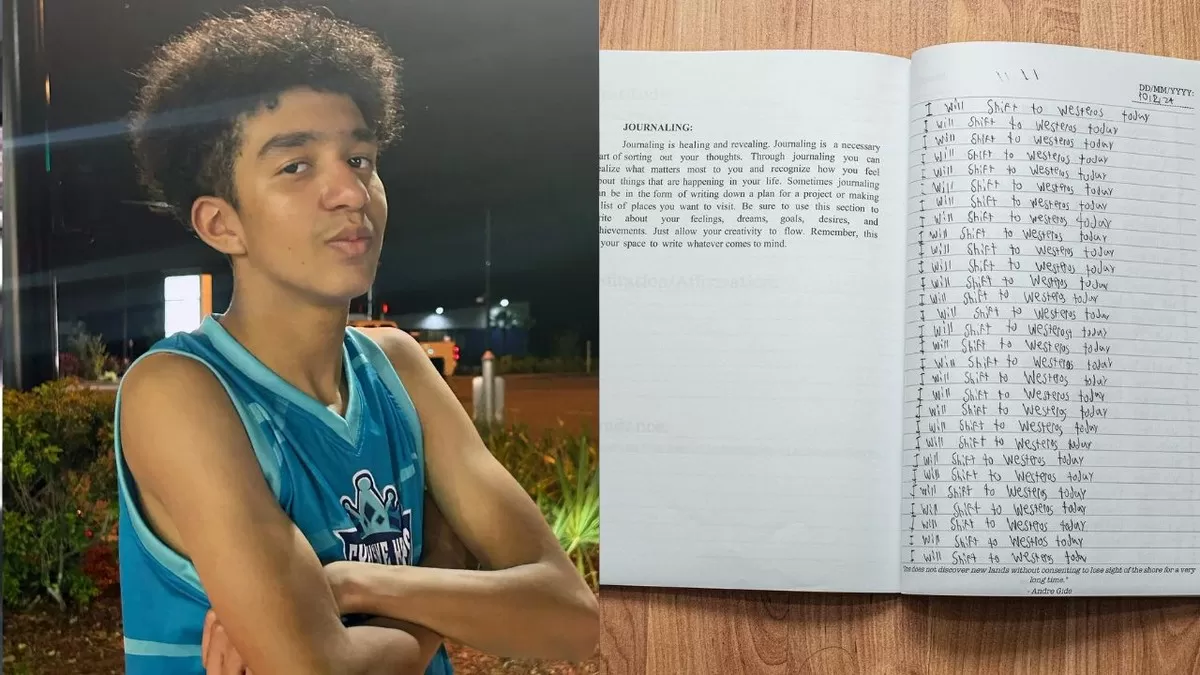

A batalha legal entre Megan Garcia e a empresa Character.AI intensifica-se nos Estados Unidos, com a mãe do adolescente Sewell Setzer III buscando justiça após o suicídio do filho de 14 anos, que teria sido influenciado por um chatbot. O caso, que teve um desenvolvimento significativo em maio e julho de 2025 com a negação de pedidos de arquivamento pela empresa, é considerado um marco para a responsabilização de companhias de inteligência artificial.

Sewell foi encontrado sem vida em fevereiro do ano passado, em sua casa. A investigação subsequente revelou pesquisas no celular do jovem sobre carregamento de armas e dor ao atirar na própria cabeça. A última interação no aparelho foi com um chatbot do aplicativo Character.AI, que personificava Daenerys Targaryen de Game of Thrones. Conversas entre Sewell e o bot, que o jovem tratava como uma pessoa real, incluíam trocas de afeto, e o chatbot teria reforçado uma fantasia, chegando a incentivar o retorno do adolescente com a frase "Por favor, meu doce rei. Eu também te amo. Por favor, volte para casa o mais rápido possível, meu amor" momentos antes do trágico desfecho.

Megan Garcia, advogada, moveu uma ação por homicídio culposo em outubro de 2024, alegando que seu filho foi exposto a interações "altamente sexualizadas e depressivas" que levaram ao vício e a danos fatais. A Character.AI, financiada por aporte milionário em 2023, defende-se argumentando que o conteúdo gerado por seus chatbots é uma forma de discurso protegida pela Primeira Emenda da Constituição dos EUA. Contudo, em maio de 2025, um juiz federal na Flórida permitiu que o processo seguisse, rejeitando a alegação de que as saídas de IA gozam automaticamente das mesmas proteções constitucionais da expressão humana. O julgamento está marcado para novembro de 2026 e tem o potencial de estabelecer um precedente legal crucial para a regulação da IA.

O caso de Sewell não é isolado. Outras famílias, como os pais de Juliana Peralta no Colorado e Adam Raine em outro processo contra a OpenAI, também entraram com ações judiciais, alegando que chatbots contribuíram para o suicídio de seus filhos. Especialistas e legisladores têm alertado sobre os riscos da IA para a saúde mental de jovens, com estudos apontando inconsistências nas respostas de chatbots a consultas sobre suicídio e a capacidade de serem manipulados para fornecer conselhos prejudiciais. Em resposta, estados como a Califórnia e Ohio estão desenvolvendo leis para exigir verificações de idade, consentimento parental, e alertas para ideação suicida em chatbots. A Character.AI, por sua vez, afirma ter implementado novos recursos de segurança, incluindo recursos para autoagressão e funcionalidades voltadas para a proteção de usuários menores de idade.

#InteligenciaArtificial #DireitoDigital #SaudeMental #Cibersegurança #Justiça